用 Antigravity 讓 AI 自己做出一個完整產品:Site Health AI Auditor(含完整教學)

🚀 我用 Google Antigravity 做了一個實驗…

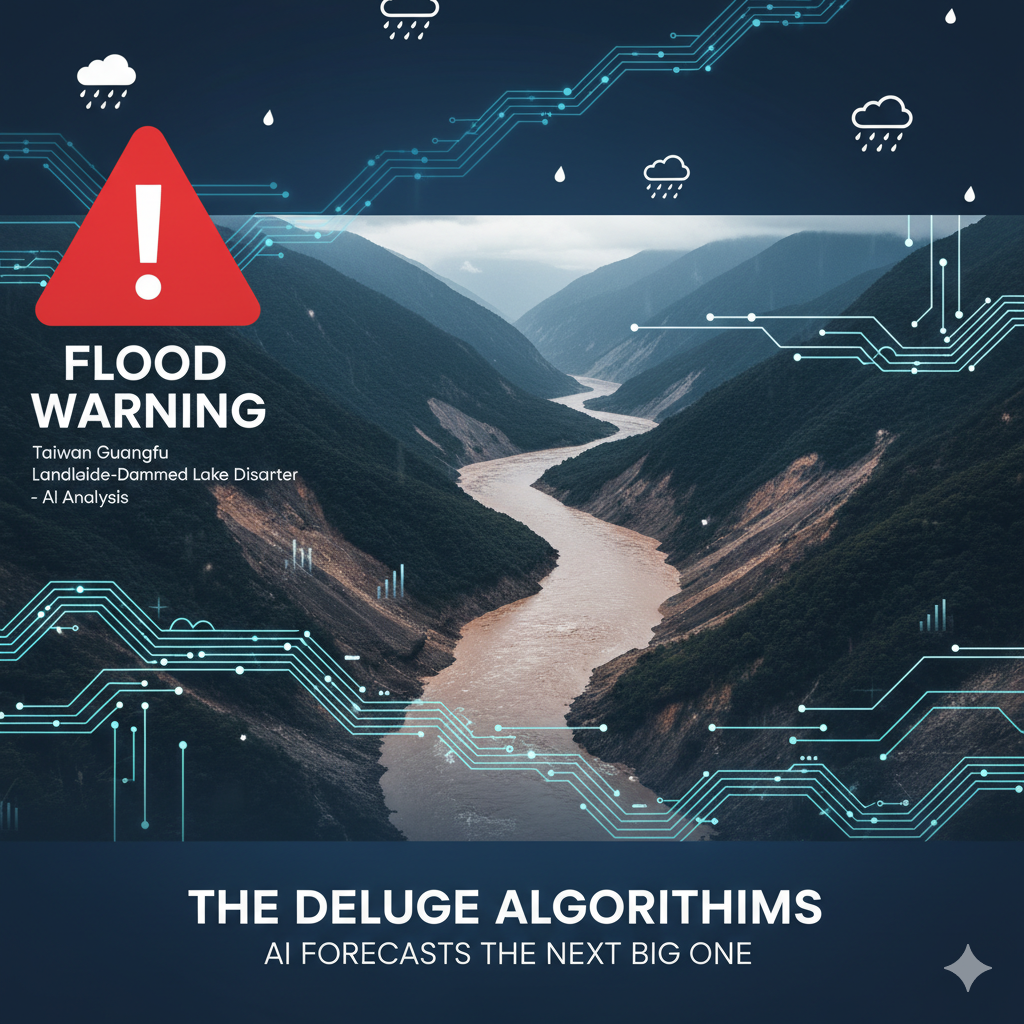

從光復堰塞湖潰流談 AI 防災:國際經驗、NCDR 覆盤與台灣的可能路徑

花蓮光復堰塞湖潰流事件再次凸顯台灣山區複合型災害的挑戰。本文透過 NCDR 工具覆盤,並對照 Google Flood Hub 與國際冰湖潰決案例,探討 AI 如何結合雨量、水位、遙感資料,朝「鏈式災害預警」邁進。

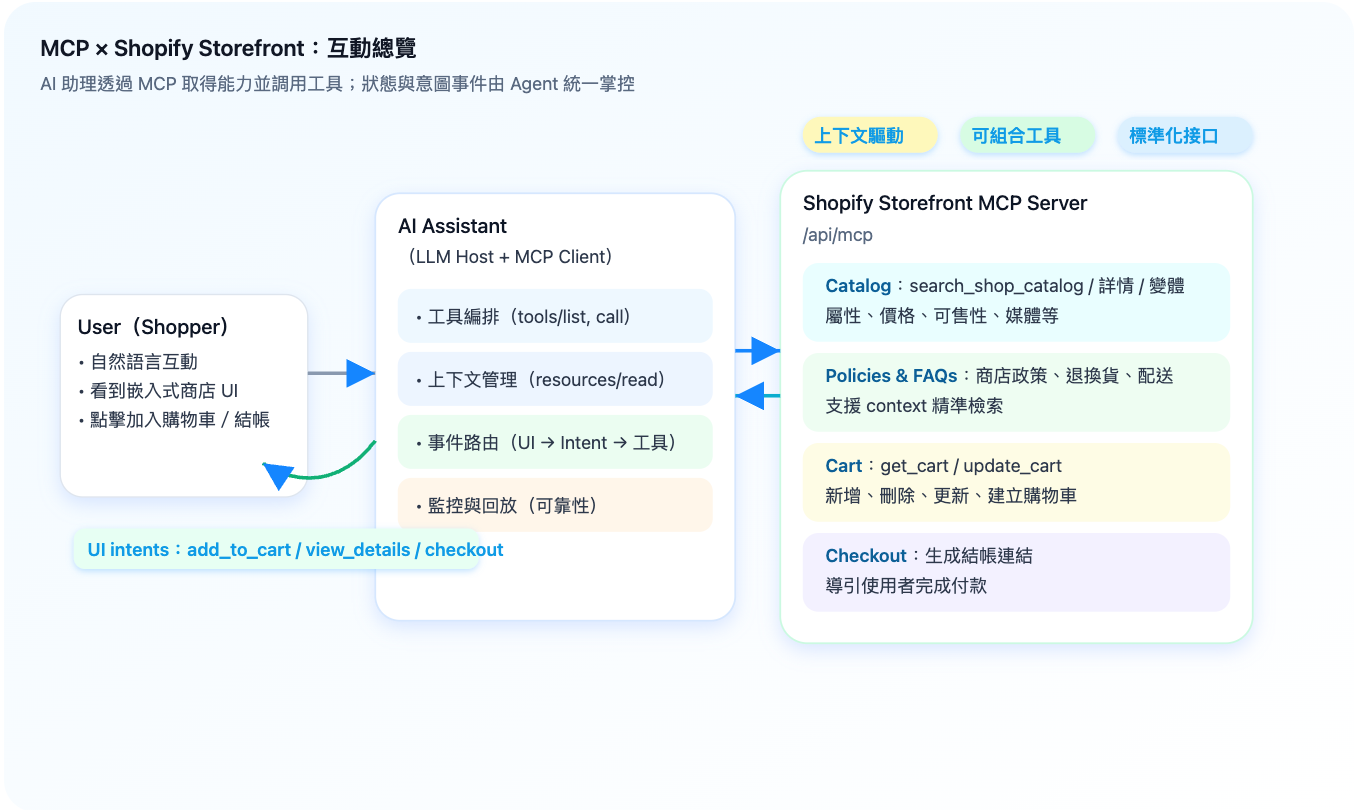

【AI Agent 實戰系列】讓 AI 幫你逛街、挑選、結帳:Shopify Storefront MCP 這樣做

把 Shopify Storefront 能力用 MCP 標準化,從工具編排、上下文到事件路由與 UI 回填,打造能「確實完成任務」的 AI 購物體驗。

進階微調 Mistral-7B 模型的方法:直接偏好優化

預訓練的大型語言模型(LLM)只能進行下一個詞預測,使得它們無法回答問題。這就是為什麼這些基礎模型之後需要通過指令和答案的配對進行精調,以充當有用的助手。然而,這個過程仍可能存在缺陷:精調後的 LLM 可能會有偏見、有毒害、有害等。這就是人類反饋中的強化學習(RLHF)發揮作用的地方。